Publicado por Leticia Bravo Matute @ Equipo GNOSS

15/02/2023

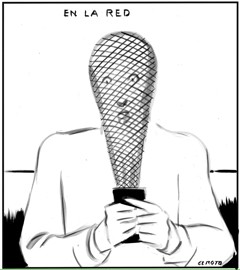

El pasado 12 febrero, El Roto publicó en El País la viñeta que acompaña a esta publicación, donde sintetizaba de un modo genial el sino de nuestra generación: en los tiempos de la Inteligencia Artificial vivimos atrapados en La Red. “Hubo un tiempo en el que buscábamos en Google; ahora Google busca en nosotros” decía Susana Zuboff en una entrevista con Justo Barranco para La Vanguardia en octubre de 2020, realizada con motivo del lanzamiento en español de su libro La era del capitalismo de vigilancia (Paidós). En esa misma entrevista añadía que: "Facebook en 2013 hizo experimentos que mostraban cómo manipular con señal...